हमारे पिछले ब्लॉग में, हमने Hadoop परिचय . पर चर्चा की है विस्तार से। अब इस ब्लॉग में, हम इसका उत्तर देने जा रहे हैं कि Hadoop पारिस्थितिकी तंत्र क्या है और Hadoop घटकों की क्या भूमिकाएँ हैं।

इस Hadoop कंपोनेंट्स ट्यूटोरियल में, हम Hadoop परिवार के विभिन्न पारिस्थितिक तंत्र घटकों जैसे HDFS, MapReduce, YARN, Hive, HBase, Pig, Zookeeper आदि पर चर्चा करेंगे।

Hadoop पारिस्थितिकी तंत्र के इन सभी घटकों पर उनकी विशेषताओं और जिम्मेदारियों के साथ चर्चा की गई है।

Hadoop पारिस्थितिकी तंत्र ट्यूटोरियल

अपाचे हडूप बिग डेटा का सबसे शक्तिशाली उपकरण है। Hadoop पारिस्थितिकी तंत्र तीन मुख्य घटकों HDFS, MapReduce और YARN के इर्द-गिर्द घूमता है। इन Hadoop घटकों के अलावा, कुछ अन्य Hadoop पारिस्थितिकी तंत्र घटक भी हैं, जो Hadoop कार्यात्मकताओं को बढ़ावा देने में महत्वपूर्ण भूमिका निभाते हैं।

आइए अब विभिन्न Hadoop घटकों को विस्तार से समझते हैं।

ए. एचडीएफएस

Hadoop वितरित फ़ाइल सिस्टम (HDFS) Hadoop का प्राइमरी स्टोरेज सिस्टम है। एचडीएफएस कमोडिटी हार्डवेयर के क्लस्टर पर चलने वाली बहुत बड़ी फाइलों को स्टोर करता है।

यह बड़ी संख्या में छोटी फ़ाइलों के बजाय कम संख्या में बड़ी फ़ाइलों को संग्रहीत करने के सिद्धांत का पालन करता है। एचडीएफएस हार्डवेयर के खराब होने की स्थिति में भी डेटा को भरोसेमंद तरीके से स्टोर करता है। इसलिए, यह समानांतर में एक्सेस करके एप्लिकेशन को उच्च थ्रूपुट एक्सेस प्रदान करता है।

HDFS के घटक:

- NameNode- यह Hadoop क्लस्टर में मास्टर के रूप में कार्य करता है। नामेनोड मेटा-डेटा यानी ब्लॉक की संख्या, प्रतिकृतियां और अन्य विवरण संग्रहीत करता है। मेटा-डेटा मास्टर में मेमोरी में मौजूद होता है। NameNode दास नोड को कार्य सौंपता है। इसे विश्वसनीय हार्डवेयर पर तैनात करना चाहिए क्योंकि यह एचडीएफएस का केंद्रबिंदु है।

- डेटानोड - यह Hadoop क्लस्टर में स्लेव के रूप में काम करता है। Hadoop HDFS में, DataNode HDFS में वास्तविक डेटा संग्रहीत करने के लिए जिम्मेदार है। DataNode क्लाइंट के अनुरोध के अनुसार रीड एंड राइट ऑपरेशन भी करता है। DataNodes कमोडिटी हार्डवेयर पर भी परिनियोजित कर सकते हैं।

ख. MapReduce

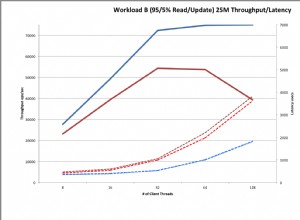

Hadoop MapReduce, Hadoop की डेटा प्रोसेसिंग लेयर है। यह एचडीएफएस में संग्रहीत बड़े संरचित और असंरचित डेटा को संसाधित करता है। MapReduce समानांतर में बड़ी मात्रा में डेटा को भी संसाधित करता है।

यह कार्य (सबमिट की गई नौकरी) को स्वतंत्र कार्यों (उप-कार्य) के एक सेट में विभाजित करके करता है। Hadoop में, MapReduce प्रोसेसिंग को चरणों में विभाजित करके काम करता है:मैप और रिड्यूस।

- मानचित्र – यह प्रसंस्करण का पहला चरण है, जहां हम सभी जटिल तर्क कोड निर्दिष्ट करते हैं।

- कम करें - यह प्रसंस्करण का दूसरा चरण है। यहां हम हल्के-फुल्के प्रसंस्करण जैसे एकत्रीकरण/योग को निर्दिष्ट करते हैं।

सी. यार्न

Hadoop YARN संसाधन प्रबंधन प्रदान करता है। यह हडूप का ऑपरेटिंग सिस्टम है। इसलिए, यह कार्यभार के प्रबंधन और निगरानी, सुरक्षा नियंत्रणों को लागू करने के लिए जिम्मेदार है। यह Hadoop क्लस्टर्स में डेटा गवर्नेंस टूल्स डिलीवर करने के लिए एक केंद्रीय प्लेटफॉर्म है।

YARN कई डेटा प्रोसेसिंग इंजन जैसे रीयल-टाइम स्ट्रीमिंग, बैच प्रोसेसिंग आदि की अनुमति देता है।

यार्न के घटक:

- संसाधन प्रबंधक - यह क्लस्टर स्तर का घटक है और मास्टर मशीन पर चलता है। इसलिए यह संसाधनों का प्रबंधन करता है और YARN के शीर्ष पर चल रहे अनुप्रयोगों को शेड्यूल करता है। इसके दो घटक हैं:अनुसूचक और अनुप्रयोग प्रबंधक।

- नोड प्रबंधक – यह एक नोड स्तर का घटक है। यह प्रत्येक गुलाम मशीन पर चलता है। यह अद्यतित रहने के लिए संसाधन प्रबंधक के साथ लगातार संवाद करता है

Apache Hive एक ओपन सोर्स डेटा वेयरहाउस सिस्टम है जिसका उपयोग Hadoop फ़ाइलों में संग्रहीत बड़े डेटासेट को क्वेरी और विश्लेषण करने के लिए किया जाता है। यह Hadoop में संरचित और अर्ध-संरचित डेटा को संसाधित करता है।

हाइव एचडीएफएस में संग्रहीत बड़े डेटासेट के विश्लेषण का भी समर्थन करता है और अमेज़ॅन एस 3 फाइल सिस्टम में भी हाइव द्वारा समर्थित है। हाइव HiveQL . नामक भाषा का उपयोग करता है (एचक्यूएल), जो एसक्यूएल के समान है। HiveQL स्वचालित रूप से SQL जैसी क्वेरी का MapReduce जॉब में अनुवाद करता है।

ई. सुअर

यह एक उच्च-स्तरीय भाषा मंच है जिसे Hadoop HDFS में संग्रहीत विशाल डेटासेट पर प्रश्नों को निष्पादित करने के लिए विकसित किया गया है। पिगलैटिन सुअर में इस्तेमाल की जाने वाली एक भाषा है जो काफी हद तक SQL से मिलती-जुलती है।

सुअर डेटा लोड करता है, आवश्यक फ़िल्टर लागू करता है और डेटा को आवश्यक प्रारूप में डंप करता है। पिग भी सभी ऑपरेशन को मैप में बदल देता है और हडूप पर प्रभावी ढंग से संसाधित होने वाले कार्यों को कम करता है।

सुअर की विशेषताएं:

- एक्सटेंसिबल – सुअर उपयोगकर्ता अपनी विशेष प्रसंस्करण आवश्यकताओं को पूरा करने के लिए कस्टम फ़ंक्शन बना सकते हैं।

- स्व-अनुकूलन – चूंकि पिग सिस्टम को स्वचालित रूप से अनुकूलित करने की अनुमति देता है। इसलिए, उपयोगकर्ता शब्दार्थ पर ध्यान केंद्रित कर सकता है।

- सभी प्रकार के डेटा को संभालता है - सुअर संरचित और असंरचित दोनों का विश्लेषण करता है।

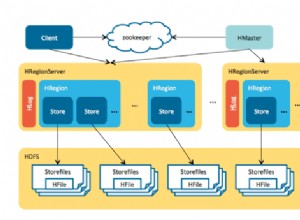

Apache HBase NoSQL डेटाबेस है जो Hadoop के शीर्ष पर चलता है। यह एक डेटाबेस है जो संरचित डेटा को उन तालिकाओं में संग्रहीत करता है जिनमें अरबों पंक्तियाँ और लाखों स्तंभ हो सकते हैं। HBase HDFS में डेटा पढ़ने या लिखने के लिए रीयल-टाइम एक्सेस भी प्रदान करता है।

HBase के घटक:

- HBase Master - यह वास्तविक डेटा संग्रहण का हिस्सा नहीं है। लेकिन यह प्रशासन (तालिका बनाने, अद्यतन करने और हटाने के लिए इंटरफ़ेस) करता है।

- क्षेत्र सर्वर – यह कार्यकर्ता नोड है। यह क्लाइंट्स से रिक्वेस्ट रीड, राइट, अपडेट और डिलीट रिक्वेस्ट को हैंडल करता है। हडूप क्लस्टर में हर नोड पर रीजन सर्वर भी प्रोसेस चलता है।

यह Apache Hadoop के शीर्ष पर टेबल और स्टोरेज मैनेजमेंट लेयर है। HCatalog हाइव का एक मुख्य घटक है। इसलिए, यह उपयोगकर्ता को अपने डेटा को किसी भी प्रारूप और संरचना में संग्रहीत करने में सक्षम बनाता है। यह क्लस्टर से डेटा को आसानी से पढ़ने और लिखने के लिए विभिन्न Hadoop घटकों का भी समर्थन करता है।

HCatalog के लाभ:

- डेटा की सफाई और संग्रह करने वाले टूल के लिए दृश्यता प्रदान करें।

- टेबल एब्स्ट्रैक्शन के साथ, HCatalog उपयोगकर्ता को डेटा संग्रहण के ऊपरी हिस्से से मुक्त करता है।

- डेटा उपलब्धता की सूचनाएं सक्षम करता है।

मैं. एवरो

यह एक ओपन सोर्स प्रोजेक्ट है जो Hadoop के लिए डेटा क्रमांकन और डेटा विनिमय सेवाएं प्रदान करता है। क्रमांकन का उपयोग करते हुए, सेवा कार्यक्रम डेटा को फाइलों या संदेशों में क्रमबद्ध कर सकते हैं।

यह डेटा परिभाषा और डेटा को एक संदेश या फ़ाइल में एक साथ संग्रहीत करता है। इसलिए, यह प्रोग्राम के लिए एवरो फ़ाइल या संदेश में संग्रहीत जानकारी को गतिशील रूप से समझना आसान बनाता है।

एव्रो प्रदान करता है:

- कंटेनर फ़ाइल, लगातार डेटा स्टोर करने के लिए।

- दूरस्थ प्रक्रिया कॉल।

- समृद्ध डेटा संरचनाएं।

- संक्षिप्त, तेज़, बाइनरी डेटा प्रारूप।

जे. मितव्ययिता

अपाचे थ्रिफ्ट एक सॉफ्टवेयर ढांचा है जो स्केलेबल क्रॉस-लैंग्वेज सेवाओं के विकास की अनुमति देता है। आरपीसी संचार के लिए थ्रिफ्ट का भी उपयोग किया जाता है। Apache Hadoop कई RPC कॉल करता है, इसलिए प्रदर्शन के लिए थ्रिफ्ट का उपयोग करने की संभावना है।

<एच4>के. ड्रिलड्रिल का उपयोग बड़े पैमाने पर डेटा प्रोसेसिंग के लिए किया जाता है। ड्रिल की डिजाइनिंग कई हजारों नोड्स और क्वेरी पेटाबाइट डेटा के पैमाने पर है। यह बड़े पैमाने के डेटासेट के लिए एक कम विलंबता वितरित क्वेरी इंजन भी है।

ड्रिल पहला वितरित SQL क्वेरी इंजन भी है जिसमें एक स्कीमा-मुक्त मॉडल है।

ड्रिल की विशेषताएं :

- विकेंद्रीकृत मेटाडेटा ड्रिल करें – ड्रिल में केंद्रीकृत मेटाडेटा आवश्यकता नहीं है। ड्रिल उपयोगकर्ताओं को डेटा क्वेरी करने के लिए मेटाडेटा में टेबल बनाने और प्रबंधित करने की आवश्यकता नहीं है।

- लचीलापन - ड्रिल पदानुक्रमित स्तंभ डेटा मॉडल प्रदान करता है। यह जटिल, अत्यधिक गतिशील डेटा का प्रतिनिधित्व कर सकता है और कुशल प्रसंस्करण की भी अनुमति देता है।

- गतिशील स्कीमा खोज – क्वेरी निष्पादन प्रक्रिया शुरू करने के लिए ड्रिल को डेटा के लिए किसी प्रकार के विनिर्देशन की आवश्यकता नहीं होती है। इसके बजाय, ड्रिल डेटा को रिकॉर्ड बैच नामक इकाइयों में संसाधित करना शुरू कर देता है। यह प्रसंस्करण के दौरान मक्खी पर स्कीमा भी खोजता है।

एल. महावत

यह एक खुला स्रोत ढांचा है जिसका उपयोग स्केलेबल मशीन लर्निंग एल्गोरिदम बनाने के लिए किया जाता है। एक बार जब हम एचडीएफएस में डेटा स्टोर कर लेते हैं, तो महावत उन बिग डेटा सेटों में अर्थपूर्ण पैटर्न को स्वचालित रूप से खोजने के लिए डेटा साइंस टूल प्रदान करता है।

<एच4>एम. स्कूपयह मुख्य रूप से डेटा आयात और निर्यात करने के लिए उपयोग किया जाता है। इसलिए, यह बाहरी स्रोतों से संबंधित Hadoop घटकों जैसे HDFS, HBase या Hive में डेटा आयात करता है। यह Hadoop से अन्य बाहरी स्रोतों को भी डेटा निर्यात करता है। Sqoop, Teradata, Netezza, Oracle, MySQL जैसे रिलेशनल डेटाबेस के साथ काम करता है।

एन. फ्लूम

Flume अपने मूल से बड़ी मात्रा में डेटा को कुशलता से एकत्र, एकत्र और स्थानांतरित करता है और इसे HDFS को वापस भेजता है। स्ट्रीमिंग डेटा प्रवाह के आधार पर इसकी एक बहुत ही सरल और लचीली वास्तुकला है। Flume दोष सहिष्णु है, एक विश्वसनीय तंत्र भी है।

Flume स्रोत से डेटा को Hadoop वातावरण में प्रवाहित करने की भी अनुमति देता है। यह एक सरल एक्स्टेंसिबल डेटा मॉडल का उपयोग करता है जो ऑनलाइन विश्लेषणात्मक अनुप्रयोग की अनुमति देता है। इसलिए, Flume का उपयोग करके हम कई सर्वरों से डेटा तुरंत Hadoop में प्राप्त कर सकते हैं।

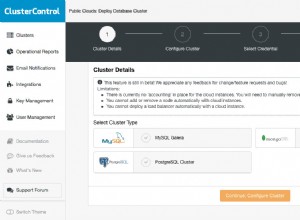

ओ. अंबारी

यह एक ओपन सोर्स मैनेजमेंट प्लेटफॉर्म है। यह Apache Hadoop क्लस्टर के प्रावधान, प्रबंधन, निगरानी और सुरक्षा के लिए एक मंच है। Hadoop प्रबंधन आसान हो जाता है क्योंकि अंबारी परिचालन नियंत्रण के लिए लगातार, सुरक्षित मंच प्रदान करता है।

अंबारी के लाभ:

- सरलीकृत इंस्टॉलेशन, कॉन्फ़िगरेशन और प्रबंधन - यह आसानी से और कुशलता से बड़े पैमाने पर क्लस्टर बना और प्रबंधित कर सकता है।

- केंद्रीकृत सुरक्षा सेटअप – अंबारी पूरे प्लेटफॉर्म पर क्लस्टर सुरक्षा को कॉन्फ़िगर करता है। यह व्यवस्थापन की जटिलता को भी कम करता है।

- अत्यधिक एक्स्टेंसिबल और अनुकूलन योग्य – कस्टम सेवाओं को प्रबंधन के तहत लाने के लिए अंबारी अत्यधिक एक्स्टेंसिबल है।

- क्लस्टर स्वास्थ्य में पूर्ण दृश्यता - अंबारी सुनिश्चित करता है कि क्लस्टर स्वस्थ है और निगरानी के लिए एक समग्र दृष्टिकोण के साथ उपलब्ध है।

पी. ज़ूकीपर

हडूप में ज़ुकीपर एक केंद्रीकृत सेवा है। यह कॉन्फ़िगरेशन जानकारी को बनाए रखता है, नामकरण करता है, और वितरित सिंक्रनाइज़ेशन प्रदान करता है। यह समूह सेवाएं भी प्रदान करता है। ज़ूकीपर मशीनों के एक बड़े समूह का प्रबंधन और समन्वय भी करता है।

ज़ूकीपर के लाभ:

- तेज़ - ज़ूकीपर वर्कलोड के साथ तेज़ है जहाँ डेटा को पढ़ना लिखने की तुलना में अधिक सामान्य है। पढ़ने/लिखने का आदर्श अनुपात 10:1 है।

- आदेश दिया गया - ज़ूकीपर सभी लेन-देन का रिकॉर्ड रखता है, जिसका उपयोग उच्च-स्तरीय के लिए भी किया जा सकता है

यह Apache Hadoop जॉब्स को प्रबंधित करने के लिए एक वर्कफ़्लो शेड्यूलर सिस्टम है। यह कई कार्यों को क्रमिक रूप से कार्य की एक तार्किक इकाई में जोड़ती है।

इसलिए, Oozie फ्रेमवर्क पूरी तरह से Apache Hadoop स्टैक, YARN के साथ एक आर्किटेक्चर सेंटर के रूप में एकीकृत है। यह Apache MapReduce, Pig, Hive, और Sqoop के लिए Hadoop जॉब का भी समर्थन करता है।

Oozie स्केलेबल है और बहुत अधिक लचीली भी है। कोई भी आसानी से नौकरियों को शुरू, रोक, निलंबित और फिर से चला सकता है। इसलिए, Oozie विफल वर्कफ़्लोज़ को फिर से चलाना बहुत आसान बनाता है। किसी विशिष्ट विफल नोड को छोड़ना भी संभव है।

Oozie नौकरियां दो प्रकार की होती हैं:

- Oozie वर्कफ़्लो - यह Hadoop जॉब्स जैसे MapReduce, Pig, Hive से बने वर्कफ़्लोज़ को स्टोर और रन करना है।

- ओजी समन्वयक – यह पूर्वनिर्धारित कार्यक्रम और डेटा की उपलब्धता के आधार पर कार्यप्रवाह कार्य चलाता है।

निष्कर्ष

इसलिए, Hadoop पारिस्थितिकी तंत्र विभिन्न घटक प्रदान करता है जो इसे इतना लोकप्रिय बनाते हैं। इन Hadoop घटकों के कारण, कई Hadoop कार्य भूमिकाएँ अब उपलब्ध हैं।

मुझे उम्मीद है कि यह हडूप इकोसिस्टम ट्यूटोरियल आपको हडूप परिवार और उनकी भूमिकाओं को समझने में बहुत मदद करेगा। यदि आपको कोई प्रश्न मिलता है, तो कृपया हमारे साथ कमेंट बॉक्स में साझा करें।