इसका मुख्य लक्ष्य Hadoop ट्यूटोरियल अपाचे हडूप फ्रेमवर्क के प्रत्येक पहलू का वर्णन करना है। मूल रूप से, इस ट्यूटोरियल को इस तरह से डिज़ाइन किया गया है कि बुनियादी बातों से Hadoop सीखना आसान होगा।

इस लेख में, हम बिग डेटा Hadoop क्या है, Hadoop की क्या आवश्यकता है, Hadoop का इतिहास क्या है, और Apache Hadoop फ्रेमवर्क के अंतिम फायदे और नुकसान जैसे सवालों के जवाब देने की पूरी कोशिश करेंगे।

हम आशा करते हैं कि इस लेख को पढ़ने के बाद, आपको Hadoop Framework क्या है, इसकी स्पष्ट समझ हो गई होगी।

Hadoop क्या है?

यह बड़ी मात्रा में डेटा सेट के वितरित भंडारण और प्रसंस्करण के लिए एक खुला स्रोत सॉफ्टवेयर ढांचा है। ओपन सोर्स का मतलब है कि यह स्वतंत्र रूप से उपलब्ध है और यहां तक कि हम आपकी आवश्यकताओं के अनुसार इसके सोर्स कोड को भी बदल सकते हैं।

यह हजारों नोड्स वाले सिस्टम पर एप्लिकेशन चलाना भी संभव बनाता है। यह वितरित फाइल सिस्टम में नोड्स के बीच तेजी से डेटा ट्रांसफर दरों का प्रावधान है। यह नोड के विफल होने की स्थिति में भी सिस्टम को संचालन जारी रखने की अनुमति देता है।

Hadoop प्रदान करता है-

- भंडारण परत - HDFS

- बैच प्रोसेसिंग इंजन - MapReduce

- संसाधन प्रबंधन परत - यार्न

Hadoop - इतिहास

2003 में, Google ने प्रोजेक्ट नच . लॉन्च किया अरबों खोजों को संभालने के लिए। साथ ही लाखों वेब पेजों को इंडेक्स करने के लिए। अक्टूबर 2003 में Google ने GFS . प्रकाशित किया (Google फाइल सिस्टम) पेपर, उसी पेपर से Hadoop की उत्पत्ति हुई थी।

2004 में, Google ने MapReduce . के साथ पेपर जारी किया . और 2005 में, नच ने संचालन करने के लिए GFS और MapReduce का उपयोग किया।

2006 में, कंप्यूटर वैज्ञानिक डौग कटिंग और माइक कैफेरेला हडोप बनाया। फरवरी 2006 में डौग कटिंग याहू में शामिल हुए . इसने Hadoop को वेब पैमाने पर चलने वाले सिस्टम में बदलने के लिए संसाधन और समर्पित टीम प्रदान की। 2007 में, Yahoo ने 100 नोड क्लस्टर पर Hadoop का उपयोग करना शुरू किया।

जनवरी 2008 में, Hadoop ने अपनी सफलता की पुष्टि करते हुए, Apache में अपना स्वयं का शीर्ष-स्तरीय प्रोजेक्ट बनाया। Yahoo! के अलावा कई अन्य कंपनियों ने Hadoop का उपयोग किया, जैसे न्यूयॉर्क टाइम्स और Facebook।

अप्रैल 2008 में, Hadoop ने टेराबाइट डेटा को सॉर्ट करने के लिए सबसे तेज़ सिस्टम बनने का विश्व रिकॉर्ड तोड़ दिया। 910-नोड क्लस्टर पर चल रहा है, 209 सेकंड में एक टेराबाइट को सॉर्ट किया गया।

दिसंबर 2011 में, Apache Hadoop ने 1.0 संस्करण जारी किया। अगस्त 2013 में, संस्करण 2.0.6 उपलब्ध था। बाद में जून 2017 में, Apache Hadoop 3.0.0-alpha4 उपलब्ध है। ASF (अपाचे सॉफ्टवेयर फाउंडेशन) Hadoop के ढांचे और प्रौद्योगिकियों के पारिस्थितिकी तंत्र का प्रबंधन और रखरखाव करता है।

Hadoop क्यों?

जैसा कि हमने परिचय सीख लिया है, अब हम यह जानने जा रहे हैं कि Hadoop की क्या आवश्यकता है?

यह “बिग डेटा . के समाधान के रूप में उभरा "समस्याएं-

<मजबूत>ए. बड़े डेटा के लिए संग्रहण – एचडीएफएस ने इस समस्या को हल किया। यह बिग डेटा को डिस्ट्रीब्यूटेड तरीके से स्टोर करता है। एचडीएफएस प्रत्येक फाइल को ब्लॉक के रूप में भी स्टोर करता है। ब्लॉक फाइल सिस्टम में डेटा की सबसे छोटी इकाई है।

मान लीजिए आपके पास 512MB डेटा है। और आपने HDFS को इस तरह कॉन्फ़िगर किया है कि यह 128Mb डेटा ब्लॉक बनाएगा। इसलिए HDFS डेटा को 4 ब्लॉक में बांटता है (512/128=4) और इसे विभिन्न डेटा नोड्स में संग्रहीत करता है। यह विभिन्न डेटानोड्स पर डेटा ब्लॉक को भी दोहराता है।

इसलिए, बड़ा डेटा संग्रहीत करना कोई चुनौती नहीं है।

<मजबूत>बी. मापनीयता - यह स्केलिंग समस्या को भी हल करता है। यह मुख्य रूप से ऊर्ध्वाधर स्केलिंग के बजाय क्षैतिज स्केलिंग पर केंद्रित है। आप आवश्यकता पड़ने पर एचडीएफएस क्लस्टर में अतिरिक्त डेटानोड जोड़ सकते हैं। अपने डेटानोड्स के संसाधनों को बढ़ाने के बजाय।

इसलिए नाटकीय रूप से प्रदर्शन में वृद्धि।

<मजबूत>सी. डेटा की विविधता को संग्रहित करना – एचडीएफएस ने इस समस्या को हल किया। एचडीएफएस सभी प्रकार के डेटा (संरचित, अर्ध-संरचित या असंरचित) संग्रहीत कर सकता है। यह एक बार लिखने और कई मॉडलों को पढ़ने . का अनुसरण भी करता है ।

इसके कारण, आप किसी भी प्रकार का डेटा एक बार लिख सकते हैं और अंतर्दृष्टि खोजने के लिए आप इसे कई बार पढ़ सकते हैं।

<मजबूत>डी. डाटा प्रोसेसिंग स्पीड – यह बिग डेटा की सबसे बड़ी समस्या है। इस समस्या को हल करने के लिए, गणना को डेटा के बजाय गणना के लिए डेटा पर ले जाएं। यह सिद्धांत है डेटा स्थान ।

Hadoop कोर घटक

अब हम Apache Hadoop के मुख्य घटक के बारे में विस्तार से जानेंगे। इसके 3 मुख्य घटक हैं-

- एचडीएफएस

- मैपरेडस

- यार्न(फिर भी एक अन्य संसाधन वार्ताकार)

आइए इन मुख्य घटकों पर एक-एक करके चर्चा करें।

ए. एचडीएफएस

Hadoop वितरित फ़ाइल सिस्टम (HDFS) Hadoop की प्राथमिक भंडारण प्रणाली है। एचडीएफएस कमोडिटी हार्डवेयर के क्लस्टर पर चलने वाली बहुत बड़ी फाइलों को स्टोर करता है। यह बड़ी संख्या में छोटी फ़ाइलों के बजाय कम संख्या में बड़ी फ़ाइलों को संग्रहीत करने के सिद्धांत का पालन करता है।

हार्डवेयर खराब होने की स्थिति में भी डेटा को मज़बूती से स्टोर करता है। यह समानांतर में एक्सेस करके एप्लिकेशन को उच्च-थ्रूपुट एक्सेस प्रदान करता है।

HDFS के घटक:

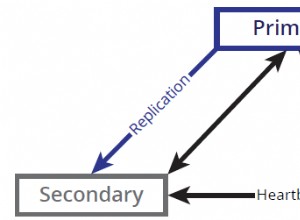

- NameNode- यह क्लस्टर में मास्टर के रूप में कार्य करता है। नामेनोड स्टोर करता है मेटा-डेटा . कई ब्लॉक, प्रतिकृतियां और अन्य विवरण। मेटा-डेटा मास्टर में मेमोरी में मौजूद होता है। NameNode स्लेव नोड्स को बनाए रखता है और उनका प्रबंधन भी करता है, और उन्हें कार्य सौंपता है। इसे विश्वसनीय हार्डवेयर पर तैनात करना चाहिए क्योंकि यह एचडीएफएस का केंद्रबिंदु है।

- डेटानोड - यह क्लस्टर में गुलाम के रूप में काम करता है। एचडीएफएस में, डेटानोड एचडीएफएस में वास्तविक डेटा संग्रहीत करने के लिए जिम्मेदार है। DataNode क्लाइंट के अनुरोध के अनुसार रीड एंड राइट ऑपरेशन करता है। DataNodes कमोडिटी हार्डवेयर पर भी परिनियोजित कर सकते हैं।

MapReduce Hadoop की डेटा प्रोसेसिंग परत है। यह एचडीएफएस में संग्रहीत बड़े संरचित और असंरचित डेटा को संसाधित करता है। MapReduce समानांतर में बड़ी मात्रा में डेटा को भी संसाधित करता है।

यह कार्य (सबमिट की गई नौकरी) को स्वतंत्र कार्यों (उप-कार्य) के एक सेट में विभाजित करके करता है। MapReduce प्रसंस्करण को चरणों में विभाजित करके काम करता है:मानचित्र और कम करें।

- मानचित्र – यह प्रसंस्करण का पहला चरण है, जहां हम सभी जटिल तर्क कोड निर्दिष्ट करते हैं।

- कम करें - यह प्रसंस्करण का दूसरा चरण है। यहां हम हल्के-फुल्के प्रसंस्करण जैसे एकत्रीकरण/योग को निर्दिष्ट करते हैं।

सी. यार्न

YARN संसाधन प्रबंधन प्रदान करता है। यह हडूप का ऑपरेटिंग सिस्टम है। यह कार्यभार के प्रबंधन और निगरानी के लिए जिम्मेदार है, सुरक्षा नियंत्रण भी लागू करता है। Apache YARN क्लस्टरों में डेटा गवर्नेंस टूल डिलीवर करने के लिए एक केंद्रीय मंच भी है।

YARN कई डेटा प्रोसेसिंग इंजन जैसे रीयल-टाइम स्ट्रीमिंग, बैच प्रोसेसिंग आदि की अनुमति देता है।

यार्न के घटक:

- संसाधन प्रबंधक - यह क्लस्टर स्तर का घटक है और मास्टर मशीन पर चलता है। यह संसाधनों का प्रबंधन करता है और YARN के शीर्ष पर चल रहे अनुप्रयोगों को शेड्यूल करता है। इसके दो घटक हैं:अनुसूचक और अनुप्रयोग प्रबंधक।

- नोड प्रबंधक – यह एक नोड स्तर का घटक है। यह प्रत्येक गुलाम मशीन पर चलता है। यह अद्यतित रहने के लिए संसाधन प्रबंधक के साथ लगातार संवाद करता है

Hadoop के लाभ

आइए अब बड़ी डेटा समस्याओं को हल करने के लिए Hadoop के विभिन्न लाभों पर चर्चा करें।

- मापनीयता – नोड्स जोड़कर हम अधिक डेटा को संभालने के लिए अपने सिस्टम को आसानी से विकसित कर सकते हैं।

- लचीलापन - इस ढांचे में, आपको इसे संग्रहीत करने से पहले डेटा को प्रीप्रोसेस करने की आवश्यकता नहीं है। आप जितना चाहें उतना डेटा स्टोर कर सकते हैं और बाद में उपयोग करने का निर्णय ले सकते हैं।

- कम लागत – ओपन सोर्स फ्रेमवर्क मुफ़्त है और कम लागत वाले कमोडिटी हार्डवेयर पर चलता है।

- गलती सहनशीलता – यदि नोड्स नीचे जाते हैं, तो कार्य स्वचालित रूप से अन्य नोड्स पर पुनर्निर्देशित हो जाते हैं।

- कम्प्यूटिंग पावर - यह . है वितरित कंप्यूटिंग मॉडल बड़े डेटा को तेजी से संसाधित करता है। आप जितने अधिक कंप्यूटिंग नोड का उपयोग करेंगे, आपके पास उतनी ही अधिक संसाधन शक्ति होगी।

Hadoop के नुकसान

Apache Hadoop फ्रेमवर्क के कुछ नुकसान नीचे दिए गए हैं-

- सुरक्षा चिंताएं – जटिल एप्लिकेशन को प्रबंधित करना चुनौतीपूर्ण हो सकता है। यदि उपयोगकर्ता यह नहीं जानता है कि प्लेटफ़ॉर्म का प्रबंधन करने वाले प्लेटफ़ॉर्म को कैसे सक्षम किया जाए, तो आपका डेटा एक बड़ा जोखिम हो सकता है। चूंकि, भंडारण और नेटवर्क स्तर Hadoop में एन्क्रिप्शन की कमी है, जो एक प्रमुख चिंता का विषय है।

- स्वभाव से कमजोर – ढांचा लगभग जावा में लिखा गया है, जो सबसे व्यापक रूप से इस्तेमाल की जाने वाली भाषा है। जावा का साइबर अपराधियों द्वारा भारी शोषण किया जाता है। नतीजतन, कई सुरक्षा उल्लंघनों में फंस गया।

- छोटे डेटा के लिए उपयुक्त नहीं - चूंकि, यह छोटे डेटा के लिए उपयुक्त नहीं है। इसलिए, इसमें छोटी फ़ाइलों के यादृच्छिक पठन को कुशलतापूर्वक समर्थन देने की क्षमता का अभाव है।

- स्थिरता की संभावित समस्याएं – चूंकि यह एक ओपन सोर्स फ्रेमवर्क है। इसका मतलब है कि यह कई डेवलपर्स द्वारा बनाया गया है जो परियोजना पर काम करना जारी रखते हैं। जबकि लगातार सुधार किए जाते हैं, इसमें स्थिरता के मुद्दे हैं। इन मुद्दों से बचने के लिए संगठनों को नवीनतम स्थिर संस्करण पर चलना चाहिए।

निष्कर्ष

अंत में, हम कह सकते हैं कि यह सबसे लोकप्रिय और शक्तिशाली बिग डेटा टूल है। यह वितरित तरीके से बड़ी मात्रा में डेटा संग्रहीत करता है।

और फिर डेटा को नोड्स के क्लस्टर पर समानांतर में संसाधित करता है। यह दुनिया की सबसे विश्वसनीय स्टोरेज लेयर- एचडीएफएस भी प्रदान करता है। बैच प्रोसेसिंग इंजन MapReduce और संसाधन प्रबंधन परत- YARN।

इसलिए, ये डेमॉन Hadoop कार्यक्षमता सुनिश्चित करते हैं।