डेटा शक्ति है और उस शक्ति के साथ बड़ी जिम्मेदारी आती है। डेटा में सबसे बड़ी बाधाओं में से एक डुप्लिकेट और डी-डुपिंग की पहचान करना है।

डेटा-डिडुप्लीकेशन का उद्देश्य आपके व्यवसाय में किसी भी अनावश्यक डेटा को समाप्त करना है। आपके व्यवसाय के सभी क्षेत्रों में डुप्लिकेट बनाए जाते हैं जैसे कि बिक्री प्रतिनिधि पहले डेटाबेस की जाँच किए बिना एक नया रिकॉर्ड इनपुट करता है, एक बाज़ारिया संभावित खरीदारों की सूची को बिना जाँच के अपलोड करता है कि क्या रिकॉर्ड मौजूद है और एक ग्राहक जो अपनी जानकारी को फिर से इनपुट करता है क्योंकि वे भूल गए थे आपके पास पहले से ही एक खाता है।

डेटा डुप्लीकेशन ऐसे रिकॉर्ड का उचित डेटा प्रबंधन, कम डेटा भंडारण, अधिक प्रभावी विपणन संचार और बेहतर भविष्य कहनेवाला विश्लेषण सुनिश्चित करता है। डुप्लीकेट रिकॉर्ड वास्तव में मशीन लर्निंग और डेटा साइंस रिकॉर्ड पर एक बड़ा प्रभाव डाल सकते हैं, सैद्धांतिक रूप से ग्राहकों को भविष्यवाणी की शक्ति से दो गुना अधिक दे सकते हैं और इसलिए आउटपुट में पूर्वाग्रह पैदा कर सकते हैं।

हालांकि, हर महान विचार के साथ जोखिम आता है और एक डी-डुप्लीकेशन रणनीति के भीतर जिसमें डेटा को ज्यादातर समय हटाया जा रहा है, अंतर्निहित गलतियां हो सकती हैं।

इन-लाइन या पोस्ट प्रोसेसिंग

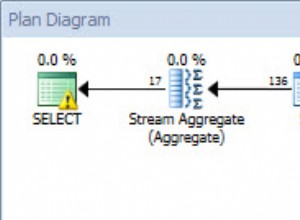

इनलाइन डिडुप्लीकेशन प्रक्रिया डेटा को संसाधित करते समय डी-डुप्लिकेट करती है। इसका मतलब यह है कि यह डेटा की मात्रा को तुरंत कम कर देता है जो कि बहुत अच्छा है लेकिन अक्सर रणनीति के रूप में चलाने के लिए आवश्यक संसाधनों की मात्रा के साथ प्रदर्शन समस्याएं होती हैं। हालांकि, इसका मतलब यह है कि आपको बहुत कम कच्चे डिस्क स्थान की आवश्यकता है क्योंकि डेटा वास्तव में पहले स्थान पर नहीं भेजा जाता है क्योंकि डिडुप्लीकेशन फ्रंट एंड पर किया जाता है।

यह महत्वपूर्ण है कि आप सुनिश्चित करें कि आपके पास इनलाइन डुप्लीकेशन के लिए प्रसंस्करण शक्ति है और यह प्रदर्शन को प्रभावित नहीं करता है। दूसरी गलती यह मान लेना है कि डुप्लीकेट होने के मामले शून्य हैं। आपके सिस्टम में डुप्लीकेट होने की वैध आवश्यकता है। कारण बिलिंग, ग्राहक सेवा, बिक्री और विपणन कारणों से हो सकते हैं, इसलिए, इन-लाइन प्रसंस्करण को लागू करने से पहले डेटा को छूने वाले सभी विभागों से परामर्श करना एक अच्छा विचार है।

एल्गोरिदम

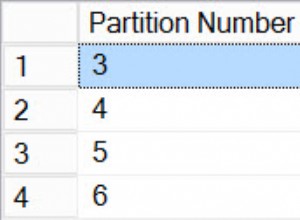

डिडुप्लीकेशन केवल उतना ही अच्छा है जितना कि इसे खिलाए गए एल्गोरिदम यानी डुप्लिकेट रिकॉर्ड पहली जगह में कैसे खोजे जाते हैं? आइए मान लें कि हमारे सिस्टम पर फ़ाइल की 100 प्रतियां हैं क्योंकि प्रत्येक कर्मचारी का अपना संस्करण था। कई प्रतियों को संग्रहीत करने के बजाय, अच्छा अभ्यास आपको केवल एक को संग्रहीत करने के लिए कहता है और सभी कर्मचारी उस ओर इशारा करते हैं। क्या होगा यदि कर्मचारियों में से एक अपनी फ़ाइल में परिवर्तन करता है जिसका अर्थ है कि यह दूसरों से थोड़ा अलग है? आप डेटा खोने का जोखिम चलाते हैं। यह सुनिश्चित करना महत्वपूर्ण है कि आपके द्वारा सेट किया गया कोई भी नियम समझ में आता है और गलती से अद्वितीय डेटासेट को हटाना शुरू नहीं करता है।

डेटा डुप्लीकेशन के लिए उपयोग किए जाने वाले कुछ सामान्य एल्गोरिदम हैं जैसे SHA-1 या MD5 और बाइनरी सर्च ट्री स्ट्रक्चर जो आपके लिए सबसे उपयुक्त है यह खोजने के लिए समीक्षा करने योग्य हैं।

जबकि ऊपर के उदाहरण में डी-डुपिंग डेटा सेट को डेटा वैज्ञानिकों द्वारा आसानी से संबोधित किया जा सकता है। बिक्री और विपणन रिकॉर्ड के लिए, यह थोड़ा अधिक कठिन है। विचार करें, कि अलग-अलग व्यवसाय डुप्लिकेट को अलग-अलग परिभाषित करते हैं, यह अब डेटा वैज्ञानिक के लिए नहीं बल्कि विभिन्न विभागों के प्रमुखों के लिए एक कार्य है। इसलिए, पहला कदम यह पहचानना है कि डुप्लिकेट क्या बनाता है। उदाहरण के लिए, वॉलमार्ट जैसी रिटेल दिग्गज को लें। वितरण कंपनी के लिए, प्रत्येक वॉलमार्ट स्थान को एक अद्वितीय रिकॉर्ड माना जाएगा, हालांकि, वॉलमार्ट में बेचने वाली एक सॉफ्टवेयर कंपनी के लिए, वे सभी स्थानों को डुप्लिकेट के रूप में मानेंगे क्योंकि वे केवल प्रधान कार्यालय में बेचना चाहते हैं। पी एंड जी में बेचने के लिए भी यही कहा जा सकता है जहां कुछ व्यवसाय प्रत्येक ब्रांड में व्यक्तिगत रूप से बेचते हैं। इसलिए, वे उन सभी को अलग रखना चाहते हैं और अलग-अलग ब्रांडों की पहचान करने के लिए डी-डुपिंग के बजाय माता-पिता/बच्चे के लिंकिंग को लागू करना चाहते हैं। इसलिए, डी-डुपिंग से पहले सुनिश्चित करें कि डेटा को डी-डुप्लिकेट करने के लिए उपयोग किए जाने वाले एल्गोरिदम का पता लगाने से पहले आपके पास सभी नियम परिभाषित हैं।

एन्क्रिप्शन

डेटा सुरक्षा के साथ, अक्सर ऐसा होता है कि सुरक्षा टीमों के पास डेटा एन्क्रिप्टेड होगा क्योंकि यह व्यवसाय में आता है जिसका अर्थ है कि इसे घटाना असंभव है क्योंकि इस संदर्भ में सब कुछ अद्वितीय है। यदि आप डुप्लीकेशन सॉफ़्टवेयर के अनुरूप प्रतिकृति और एन्क्रिप्शन उत्पादों का उपयोग कर रहे हैं, तो इस बात की बहुत अधिक संभावना है कि फ़ाइलों को दोहराया जाएगा क्योंकि यह उन्हें अद्वितीय संग्रहण ब्लॉक के रूप में नहीं चुन सकता है।

डेटा सुरक्षा उत्पाद कभी-कभी डुप्लीकेशन जागरूक होते हैं लेकिन यह महत्वपूर्ण है कि आप इस बात पर विचार करें कि सब कुछ एक साथ कैसे एकीकृत होता है।

मैन्युअल डुप्लीकेशन

अधिकांश व्यवसाय मानवीय त्रुटि के एक बड़े जोखिम के साथ अपने डेटाबेस को मैन्युअल रूप से बड़ी मात्रा में संसाधन और समय लेने का प्रयास करेंगे। इसके अलावा, विशाल डेटा सेट के साथ, मैन्युअल प्रक्रियाओं के लिए सब कुछ लेना लगभग असंभव है।

उदाहरण के लिए, क्या होगा यदि जॉन स्मिथ आज आपकी वेबसाइट पर एक जोड़ी जूते खरीदता है। वह कल वापस चला जाता है लेकिन जे स्मिथ के रूप में पंजीकरण करता है क्योंकि वह अपना लॉगिन विवरण भूल गया था। अगले हफ्ते, वह फिर से साइन अप करता है लेकिन एक अलग ईमेल पते के साथ। मैंने यहां केवल तीन डेटा फ़ील्ड का उल्लेख किया है, लेकिन यह पहले से ही जटिल होना शुरू हो गया है, इसलिए कल्पना करें कि यदि आपके पास ग्राहक डेटा के 200 फ़ील्ड हैं, तो आप यह कैसे सुनिश्चित करते हैं कि इसे अद्वितीय रखा जाए?

मैन्युअल प्रक्रिया के बारे में जाने या डेटा क्लींजिंग टूल प्राप्त करने के लिए या तो स्वयं पूर्ण एल्गोरिदम बनाना महत्वपूर्ण है, जो आपके सभी समय और प्रयास को बचाता है।

बैकअप

डुप्लीकेशन गलत हो सकता है! डुप्लीकेट हटाने से पहले, यह महत्वपूर्ण है कि हर चीज का बैकअप लिया जाए और आप किसी भी मुद्दे को जल्दी से हल कर सकें। अपने पहले के उदाहरण पर वापस जाते हुए, क्या होगा यदि हमें पता चलता है कि जॉन स्मिथ और जे स्मिथ वास्तव में अलग-अलग लोग हैं और उन्हें खाता वापस लेने की आवश्यकता है? आपको एक ऐसी प्रक्रिया की आवश्यकता है जो वह कर सके, जो अब EU (GDPR) में एक कानूनी आवश्यकता है।

डेटा डिडुप्लीकेशन रणनीति महत्वपूर्ण है क्योंकि व्यवसाय अपने डिजिटल फुटप्रिंट को बढ़ाते हैं। संचार के इतने सारे चैनलों के साथ, केवल एक डुप्लिकेट रिकॉर्ड में पूर्वाग्रह पैदा करने और संभावित रूप से गलत निर्णय लेने की क्षमता होती है। उस ने कहा, गलत रिकॉर्ड को हटाने या एल्गोरिदम को गलत तरीके से फीड करने और व्यवसाय की गति को कम करने के परिणामों से बचने के लिए इसे ठीक से किया जाना चाहिए। सुनिश्चित करें कि डेटा डुप्लीकेशन पूरी तरह से आपकी डेटा शासन रणनीति के भीतर बना है।