टन डेटा से निपटने के लिए कुछ विशेष व्यवस्था की आवश्यकता होती है। डेटा की बाढ़ को संभालने के लिए सामान्य कम्प्यूटेशनल तकनीक अपर्याप्त हैं; और अधिक, जब वे कई स्रोतों से आ रहे हैं। बिग डेटा में, हम जिस परिमाण के बारे में बात कर रहे हैं वह बड़े पैमाने पर है - ज़ेटाबाइट्स, एक्साबाइट्स, या लाखों पेटाबाइट्स या अरबों टेराबाइट्स में मापा जाता है। Hadoop . नामक ढांचा बिग डेटा प्रबंधन के साथ कुछ मुद्दों को संभालने के लिए लोकप्रिय रूप से उपयोग किया जाता है। यह लेख बिग डेटा के आलोक में Hadoop के बारे में एक परिचयात्मक विचार देने का प्रयास करता है।

विकास

बड़े धमाके से कुछ नहीं होता। Hadoop की उत्पत्ति और विकास क्रमिक है और बिग डेटा से निपटने में समय की आवश्यकता के अनुसार है। संक्षेप में बताने के लिए, इसकी उत्पत्ति वर्ष 2003 में डौग कटिंग की अपाचे नच परियोजना के कारण हुई, विशेष रूप से शुरुआत में इसका कोड भाग। उत्पत्ति को Google फ़ाइल सिस्टम (GFS) से विकसित किया गया था, एक पेपर जो अक्टूबर 2003 में प्रकाशित हुआ था, जिसने MapReduce नामक एक अन्य पेपर को प्रभावित किया:बड़े समूहों पर सरलीकृत डेटा प्रोसेसिंग। Hadoop में HDFS के लिए कोड को 2006 में Apache Nutch प्रोजेक्ट से अलग किया गया है और यह GFS और MapReduce एल्गोरिदम से बहुत प्रभावित है। और, तथ्य यह है कि "हडूप" नाम कटिंग के बेटे के भरवां हाथी के खिलौने से आया है, यह स्पष्ट रूप से इस विचार को प्रतिध्वनित करता है कि कमरे में एक हाथी है जिसे हडोप स्पष्ट रूप से संबोधित करना या उससे निपटना चाहता है।

संक्षेप में

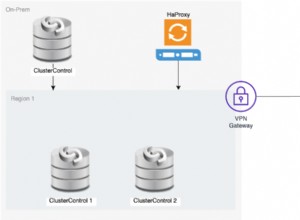

आज, Hadoop अपनी अखंड शुरुआत से एक सॉफ्टवेयर लाइब्रेरी के रूप में विकसित हो गया है, जो अनुप्रयोगों को विकसित करने के लिए एक ढांचा है, जिसमें सरल प्रोग्रामिंग मॉडल का उपयोग करके कंप्यूटर के समूहों में भारी मात्रा में डेटा के वितरित प्रसंस्करण की आवश्यकता होती है। यह सिंगल सर्वर से हजारों मशीनों तक बढ़ सकता है। डेटा के बड़े सेट के प्रसंस्करण का लाभ उठाने के लिए कई कंप्यूटरों में गणना और भंडारण वितरित करने का विचार है। लाइब्रेरी में एप्लिकेशन लेयर के स्तर पर विफलताओं का पता लगाने की क्षमता है ताकि प्रोग्रामर उन्हें संभाल सके और एक या अधिक निचले स्तरों पर विफलता को कम करने के बजाय कंप्यूटर के क्लस्टर के शीर्ष पर सेवा प्रदान कर सके जहां यह अधिक कठिन हो जाता है प्रबंधित करें या दूर करें।

इसलिए, Hadoop, वितरित कंप्यूटिंग के लिए एप्लिकेशन बनाने के लिए Apache द्वारा समर्थित टूल और ओपन सोर्स लाइब्रेरी का एक संयोजन है जो अत्यधिक विश्वसनीय और स्केलेबल है।

यह कैसे काम करता है

Hadoop मूल रूप से Big Data से निपटने के तीन तरीके हैं:

- पहला मुद्दा भंडारण है। डेटा को कई कंप्यूटिंग मशीनों में एक वितरित वातावरण में संग्रहीत किया जाता है जहां उन्हें समय और संसाधनों को कम करने के लिए समानांतर में संसाधित किया जा सकता है। डेटा Hadoop डिस्ट्रिब्यूटेड फ़ाइल सिस्टम (HDFS) नामक परिवेश में बना रहता है , जिसका उपयोग मशीनों के समूहों में डेटा को कई स्वरूपों में संग्रहीत करने के लिए किया जाता है। इस उद्देश्य के लिए, यह डेटा को ब्लॉक में विभाजित करता है और इसे विभिन्न डेटा नोड्स में संग्रहीत करता है। यह क्षैतिज स्केलिंग . नामक तकनीक का उपयोग करता है आवश्यकता के अनुसार मौजूदा एचडीएफएस क्लस्टर में अतिरिक्त डेटा नोड्स जोड़ने के लिए। यह मौजूदा संसाधनों के उपयोग को अधिकतम करने के बजाय एक को जोड़ने के बजाय जब भी बड़े पैमाने पर करने की आवश्यकता होती है।

- दूसरा मुद्दा डेटा की विविधता को समायोजित करना है। एचडीएफएस सभी प्रकार के डेटा को स्टोर करने के लिए सुसज्जित है, चाहे वह संरचित, अर्ध-संरचित या असंरचित हो। कोई प्री-डंपिंग स्कीमा सत्यापन नहीं है। डेटा, एक बार लिखे जाने के बाद, बिना किसी समस्या के कई बार पढ़ा जा सकता है।

- तीसरा मुद्दा प्रसंस्करण और संग्रहीत डेटा तक कैसे पहुंचना है। इस संबंध में, MapReduce एल्गोरिथ्म बचाव में आता है, जहां प्रसंस्करण को समानांतर में काम करने के लिए दास नोड्स में वितरित किया जाता है और परिणाम मास्टर नोड को वापस भेज दिया जाता है। मास्टर नोड अंतिम परिणाम प्रस्तुत करने से पहले परिणामों को मर्ज करता है। इस भाग को YARN द्वारा नियंत्रित किया जाता है, जिसे HDFS में संग्रहीत डेटा के समानांतर प्रसंस्करण के लिए डिज़ाइन किया गया है।

इसके कई जटिल भाग हैं, लेकिन संक्षेप में Hadoop यही करता है। मॉड्यूल का विचार और अधिक जानकारी देगा।

मॉड्यूल

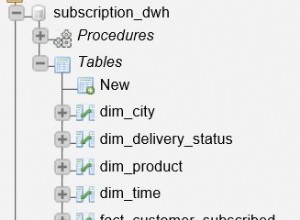

Apache Hadoop प्रोजेक्ट में छह मॉड्यूल शामिल हैं। पहले चार इस प्रकार हैं:

- हडूप कॉमन :इसमें आमतौर पर Hadoop द्वारा उपयोग की जाने वाली उपयोगिताएँ होती हैं और अन्य Hadoop मॉड्यूल का समर्थन करती हैं। इसे Hadoop Core . के नाम से भी जाना जाता है और HDFS, YARN और MapReduce के साथ पारिस्थितिकी तंत्र का एक अनिवार्य हिस्सा है। इसी भाग में Hadoop मानता है कि हार्डवेयर के विफल होने का खतरा है और प्रोग्रामर को सॉफ़्टवेयर में विफलता को स्वचालित रूप से संभालने के लिए कोई भी आवश्यक साधन प्रदान किया जाता है।

- Hadoop डिस्ट्रिब्यूटेड फाइल सिस्टम (HDFS) :एक वितरित फाइल सिस्टम जो एक वितरित वातावरण में विभिन्न फाइलों को समायोजित कर सकता है। यह फ़ाइलों को ब्लॉक में तोड़ता है और उन्हें वितरित आर्किटेक्चर में नोड्स में संग्रहीत करता है। यह अतिरिक्त क्लस्टरिंग के लिए लंबवत स्केलिंग के बजाय क्षैतिज स्केलिंग प्रदान करता है। यह हार्डवेयर परिनियोजन क्षमताओं के मामले में अत्यधिक दोष-सहिष्णु और कम लागत वाला है।

- हडूप यार्न :यह हडूप ढांचे का सीपीयू है। NodeManager called नामक दो प्रमुख घटकों के साथ और संसाधन प्रबंधक , YARN संसाधन आवंटन, कार्य शेड्यूलिंग और क्लस्टर प्रबंधन जैसी सभी संसाधन गतिविधियों को करता है।

- Hadoop MapReduce :यह सभी समानांतर गणना करने के लिए एक ढांचा है। MapReduce एक वितरित वातावरण में डेटा को संसाधित करने के लिए एक समानांतर प्रोग्रामिंग मॉडल है। यह आदर्श रूप से वितरित अनुप्रयोगों को लिखने के लिए उपयोग किया जाता है जो कमोडिटी हार्डवेयर के समूहों में बड़ी मात्रा में डेटा को कुशलतापूर्वक संसाधित कर सकते हैं। यह प्रक्रिया को दो चरणों में विभाजित करता है, जिसे मानचित्र . कहा जाता है और कम करें , जहां मैपर . का कार्य है कक्षा इनपुट लेना, टोकन करना, नक्शा बनाना और इसे सॉर्ट करना है। तब आउटपुट Reducer . का इनपुट बन जाता है वर्ग, जो मेल खाने वाले जोड़े खोजता है और उन्हें कम करता है। प्रत्येक चरण में इनपुट और आउटपुट के लिए कुंजी-मूल्य जोड़े होते हैं, और जोड़ी का प्रकार प्रोग्रामर द्वारा निर्धारित किया जाता है।

हाल ही में दो नई उप-परियोजनाएं जोड़ी गई हैं:

- हडूप ओजोन :यह Hadoop के लिए एक स्केलेबल, निरर्थक और वितरित ऑब्जेक्ट स्टोर है। अलग-अलग आकार की अरबों वस्तुओं को स्केल करने के अलावा, ओजोन कंटेनरीकृत वातावरण जैसे कुबेरनेट्स और यार्न में प्रभावी ढंग से कार्य कर सकता है। यह Hadoop डिस्ट्रिब्यूटेड डेटा स्टोर (HDDS) नामक अत्यधिक उपलब्ध, प्रतिकृति ब्लॉक स्टोरेज लेयर पर बनाया गया है। . [अंश। अधिक जानने के लिए क्लिक करें।]

- हडूप पनडुब्बी :Hadoop के लिए एक मशीन लर्निंग इंजन। यह एक ऐसा प्रोजेक्ट है जो एक इंफ्रा इंजीनियर/डेटा वैज्ञानिक को संसाधन प्रबंधन प्लेटफॉर्म (जैसे YARN) पर गहन शिक्षण एप्लिकेशन (टेन्सरफ़्लो, पाइटोरच, और आगे) चलाने की अनुमति देता है। [अंश। अधिक जानने के लिए क्लिक करें।]

निष्कर्ष

Hadoop ने कई प्रमुख संगठनों, जैसे Amazon, Facebook, Yahoo, आदि की लॉगिंग प्रक्रिया, डेटा वेयरहाउसिंग और बिग डेटा एनालिटिक्स में खोजों पर महत्वपूर्ण प्रभाव डाला है। यह लगभग असीमित समवर्ती नौकरियों का दोहन करने के लिए स्केलेबल प्रोसेसिंग पावर के साथ किसी भी प्रकार के डेटा की भारी मात्रा को संग्रहीत करने के लिए एक स्टॉप समाधान है। कुछ शब्दों में, Hadoop की लोकप्रियता इसके दोष-सहिष्णु, स्केलेबल, लागत प्रभावी और तेज क्षमता के कारण है।